En nuestros grupos y foros hemos visto mil veces comentarios y preguntas sobre los diferentes formatos de HDR que tenemos actualmente disponibles. Como ya sabéis, el «básico» es el HDR10, pero también tenemos dos formatos de HDR dinámico muy conocidos: Dolby Vision y HDR10+. Esto hace que muchas veces nos preguntemos, ¿es mejor el Dolby Vision que el HDR10? Y también nos preguntan muy a menudo, ¿es necesario el Dolby Vision? Esta última pregunta es muy difícil de contestar, pero luego intentaremos dar un poco de luz sobre el tema.

Pero antes os queríamos hablar de un artículo que ha publicado la propia Dolby y que nos ha parecido bastante interesante. En este artículo analiza la diferencia entre HDR10 y Dolby Vision. Aunque como es lógico lo hacen desde su punto de vista, es decir, siempre van a «tirar» hacia el Dolby Vision, cuentan algunas cosas y realizan unas comparativas que nos han parecido interesantes. Así que nos ha parecido buena idea echarle un vistazo.

¿Qué es el HDR y por qué es importante?

En AVPasión siempre hemos defendido que la verdadera revolución en la calidad de imagen de los televisores la tenemos en el HDR y no en la resolución. Si bien es cierto que la resolución 4K ha supuesto un salto importante en el nivel de detalle, el alto rango dinámico es posiblemente más importante para obtener una imagen que destaque.

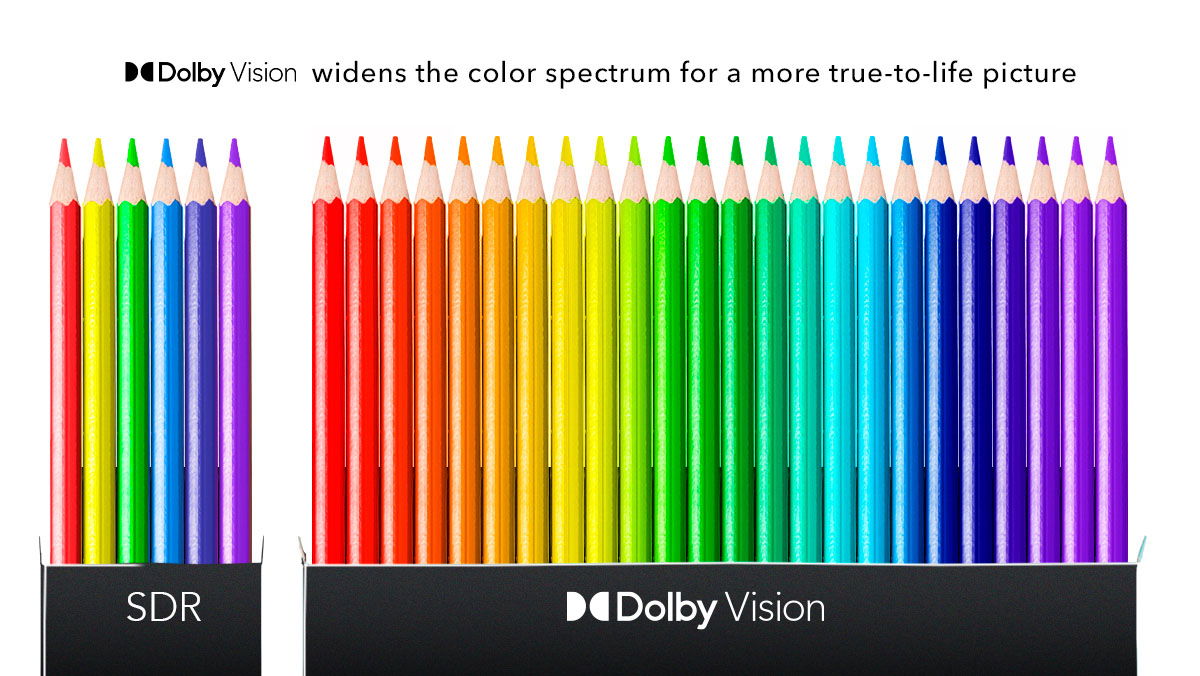

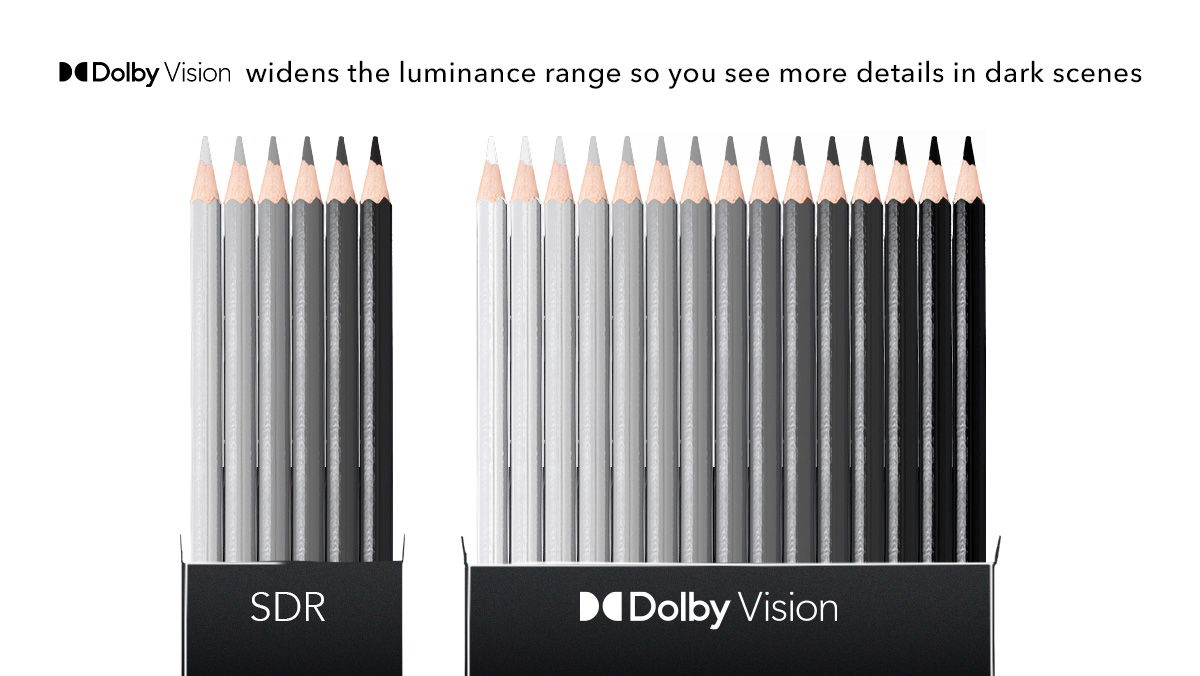

En pocas palabras, el HDR es una forma de hacer que la imagen sea más vibrante y real, con mejor brillo, contraste y color. Las pantallas antiguas solo podían reproducir contenido en el rango dinámico estándar (SDR), que está limitado a un color de 8 bits, lo que significa que solo podía producir unos 16 millones de colores. El brillo SDR está limitado a unos 100 nits de brillo máximo. Un nit, por si te lo estás preguntando, es una unidad que se utiliza para medir el brillo. Un número más alto significa una pantalla más brillante.

Por otro lado, los televisores SDR normalmente tenían una relación de contraste máxima de aproximadamente 1200:1, lo que significa que la imagen más brillante que podían mostrar sería unas 1200 veces más brillante que la imagen más oscura. Y también se debe tener en cuenta la resolución de color, que define la gama de colores y el contraste que un televisor es capaz de mostrar para reproducir una imagen.

Los televisores actuales cuentan con resolución 4K UHD y HDR. El HDR aumenta el brillo potencial de las pantallas HDR a partir de unos 300 nits. Algunos televisores que se encuentran actualmente a la venta superan los 1000 nits de brillo, y otros son incluso más brillantes. Además, la relación de contraste de HDR es básicamente infinita. Esto significa que las partes brillantes de una escena pueden ser mucho más brillantes que con SDR, y las partes oscuras pueden ser más oscuras. Gracias al HDR es posible ver detalles en las sombras incluso cuando las partes iluminadas de una escena sean muy brillantes.

Pero el HDR no solo es brillo, también admite más colores. Todos los televisores que se vendan como HDR ofrecerán HDR10, la versión básica de HDR. Esta tiene un color de 10 bits y puede reproducir alrededor de mil millones de colores únicos. Si bien eso puede parecer mucho, es mucho menos de lo que vemos todos los días en el mundo real.

El Dolby Vision es una forma mejorada de HDR que puede usar color de 12 bits, lo que da como resultado alrededor de 68 mil millones de colores. Esto debería traducirse en una imagen increíblemente más rica y realista. No todos los televisores HDR 4K pueden mostrar Dolby Vision, pero todos los televisores habilitados con Dolby Vision también pueden mostrar contenido HDR10, por lo que el HDR «básico» siempre lo tendremos a nuestra disposición.

La diferencia entre HDR10 y Dolby Vision … según Dolby

Como hemos visto, el sistema Dolby Vision ofrece una mejor representación de los colores y un mayor brillo. Sin embargo, hay algo más que lo diferencia del HDR10: los metadatos dinámicos. Podemos ver los metadatos HDR como un manual de instrucciones integrado para las pantallas de hardware (TV, móvil u ordenador) que les indica cómo mostrar la imagen. El HDR10 utiliza metadatos estáticos, lo que significa que los ajustes se basan en los mejores valores medios para el contenido.

Los metadatos dinámicos utilizan diferentes ajustes optimizados para cada escena y aprovechan al máximo las diferentes capacidades de cada pantalla HDR. Esto ofrece la versión más realista del contenido emitido, ajustando automáticamente los cambios de luz y oscuridad entre tomas (ya sean sutiles o sustanciales) para que la visualización sea lo más agradable posible.

El estándar HDR10 también cuenta con un formato «libre» de HDR dinámico. Se trata del HDR10+ y marcas como Samsung han apostado por él (en gran medida porque para incluir Dolby Vision se debe pagar una licencia). El HDR10+ utiliza color de 10 bits y metadatos dinámicos, aunque es cierto que la mayoría de plataformas de streaming e incluso medios físicos han apostado por el Dolby Vision. El HDR10+ es mucho menos habitual, aunque se está empezando a ver en plataformas como Apple TV+. Aún así, tiene mucho camino por recorrer.

Así que, sobre el papel, el formato Dolby Vision es superior al HDR10. Ofrece un mayor brillo, mayor contraste, mejor representación del color y un mayor rango de luminancia con un ajuste dinámico de la imagen. Entonces, ¿por qué en muchas ocasiones hemos oído que el Dolby Vision no vale la pena? El mayor problema que hemos detectado es que en muchas ocasiones el Dolby Vision no está bien implementado en los televisores.

Son muy pocas las marcas que consiguen una implementación correcta del formato de Dolby, lo cual hace que muchas veces el usar el Dolby Vision sea más una desventaja que una ventaja.

Fuente | Dolby