Dolby Vision, el término de moda que todo el mundo busca en su televisor, aunque suponga algo más de sugestión que de mejora real en la mayoría de ocasiones o incluso, como iremos viendo en este artículo, un empeoramiento de la imagen. ¿Pero, por qué es tan complicado hacer que funcione bien en las diferentes marcas de Smart TV? por una serie de motivos que iremos desgranando a lo largo del artículo.

Si no estás familiarizado con los términos de metadatos dinámicos, valores de corte, roll-off, capas, etc., deberías pasarte por nuestro artículo dedicado a Dolby Vision. En él veréis las principales diferencias entre las capas de las que hablaremos hoy aquí, en buena parte culpables de que haya tanta fragmentación en el mercado. Al margen de eso, debéis tener claro también que tanto el dispositivo como el visualizador (televisor, proyector, etc.) deben ser totalmente compatibles como Dolby Vision para poder reproducirlo.

Éstos son los motivos por los que Dolby Vision es un infierno de implementar en los televisores

Para comprender bien la magnitud del problema tenemos que entender lo básico y eso significa, para quedarnos con lo esencial, que Dolby Vision es un formato más de la especificación HDR (al igual que el HDR10 o el HDR10+), que por cierto fueron todos creados por la misma mente: Dolby Labs. La diferencia la encontramos en cómo funcionan.

Mientras el formato HDR10 normal establece una misma curva para toda la película (con varios datos como frame más brillante, punto más brillante, brillo del monitor usado para la película, etc.), en el caso de Dolby Vision va más allá: la pista ya contiene información precisa frame a frame de dónde y cómo usar el brillo. Será luego, el propio televisor, el que «indique» cual es su brillo máximo y adopte así toda esa información para que se vea perfectamente…¿o no?

Uno viendo toda esa información pensaría rápidamente que el formato Dolby Vision es el claro ganador al adaptar el brillo escena a escena, pero ahí entramos en el choque entre el plano teórico y el práctico. En el práctico, el sin fin de versiones del códec Dolby Vision (3 importantes hasta la fecha, actualmente transitando entre la 2.9 y la 4.0) provoca que los televisores no actúen correctamente. Además, se añaden dos problemas más: las diferencias entre la multitud de perfiles que hay y las diferencias entre capas.

¿Y hay más? pues si, ya que hay dos formas de implementar Dolby Vision: la de baja latencia LLM y la normal (completa). Los televisores usarán una u otra en función de la potencia del chip que integren, siendo ya lo normal en gama alta que utilicen la versión completa. Aún así, debido a los puntos anteriores y a la dificultad técnica, incluso aunque nuestro televisor y reproductor soporten la última versión, perfil y modo completo, seguirá viéndose peor que el HDR normal…gracias en parte a la llegada de los mapeadores de tonos.

La llegada del mapeo tonal dinámico pone en aprietos a Dolby Vision

Como os comentábamos al principio del artículo, no hemos querido marearos con las diferencias entre perfiles, capas y versiones de Dolby Vision, solo queríamos que tuvierais claro que tal fragmentación -unida a la dificultad y a la necesidad de integración y aprobación por parte de Dolby en cada modelo- es parte de la culpa de la mala implementación y peor imagen en muchos casos que la versión HDR. El otro motivo es la llegada de los mapeadores dinámicos de tonos.

Esta tecnología simplemente simula el funcionamiento de Dolby Vision. En lugar de basarse en los viejos metadatos incrustados en la capa HDR de nits del monitor de masterizado, solo utilizan dos datos para generar la información: nits promedios de la película (MaxCLL) y el punto más brillante de la misma (MaxFALL). En función de esto, el brillo máximo que tenga nuestro televisor y una serie de cálculos internos, nuestro televisor irá modificando la escena en tiempo real igual que lo haría Dolby Vision.

El resultado es magnífico en la mayoría de televisores modernos, prácticamente idéntico a la mejor implementación posible de Dolby Vision hecha hasta la fecha que tiene el honor de ser la de los televisores Panasonic. Aunque existan diferencias a favor de Dolby Vision en ese caso -y solo con esa marca- son realmente pequeñas.

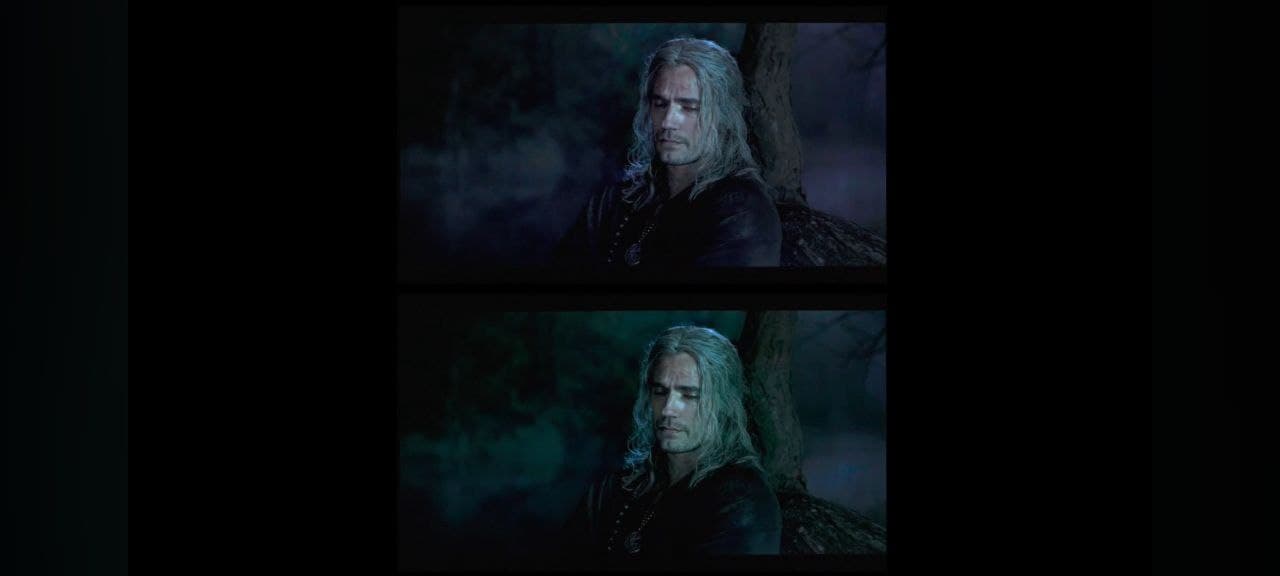

En el resto de televisores actuales, el resultado de Dolby Vision suele ser peor: o aplasta más detalle en sombra del que debería, o menos, o se lava la imagen, o está demasiado oscura, etc., debido a la dificultad técnica de las marcas y especialmente de los chips que integran de implementar bien el motor de Dolby. El último caso es el de la Sony A95L:

Como podéis apreciar, el look de Dolby Vision es totalmente incorrecto: muy verdoso y con la imagen mucho más lavada de lo normal debido a una mala implementación de este formato. Así que, aunque en la teoría es mejor, en la práctica y en el caso más normal suele ser peor debido a su propia e intrínseca dificultad y fragmentación. En cambio en el HDR10 normal, al ser tan simple, es mucho más sencillo de que funcione como debería. A veces la clave del éxito está en simplificar.