La profundidad de la señal del vídeo, es una medida importante de la calidad de la imagen y siempre se relaciona con otros términos que veremos en los próximos artículos: espacio de color y gamma. Si no eres asiduo a la terminología de vídeo, te sugerimos pasar primero por los vídeos de la Academia de AVPasión.

Si un espacio de color especifica un rango de tonalidades de color disponibles, entonces la profundidad de bits define la precisión que se puede asociar a esas variaciones.

Es decir, la profundidad de bits determina la precisión con la que se puede especificar la diferencia entre un color y otro parecido del mismo tono. Recuerda que tampoco se percibe de la misma forma el color en un televisor que en otro con otra tecnología, como es el caso de las QD-OLED por ejemplo.

¿Cual es la diferencia entre una profundidad del bit alta y baja?

Una profundidad de bits baja limita los posibles valores que se pueden usar al representar una imagen, tanto es luminancia (del blanco al negro con su escala de grises) como en su crominancia (los colores primarios lumínicos son rojo, verde y azul). En el caso de una imagen en escala de grises de 3 bits, solo hay 8 valores posibles.

Esto se debe a que 3 bits es otra forma de decir 2x2x2 = 8. Por otro lado, si usamos 8 bits, tenemos hasta 256 valores que podemos usar para reproducir la misma imagen (2 elevado a 8 = 256, es decir, del 0 al 255). Esto da como resultado una imagen mucho más suave y continua porque podemos ser más precisos en la forma en que definimos las diferencias sutiles entre las sombras.

Imágenes RGB

Ahora que tenemos la idea con las imágenes en escala de grises, apliquemos este conocimiento a las imágenes en color. Las imágenes en color se crean mezclando tres canales, a saber, rojo, verde y azul (en inglés red, green, blue, RGB). Puedes profundizar más al respecto de la colorimetría RGB pulsando aquí.

Debido a que tenemos 3 canales, significa que ahora tenemos 3 veces la cantidad de datos.

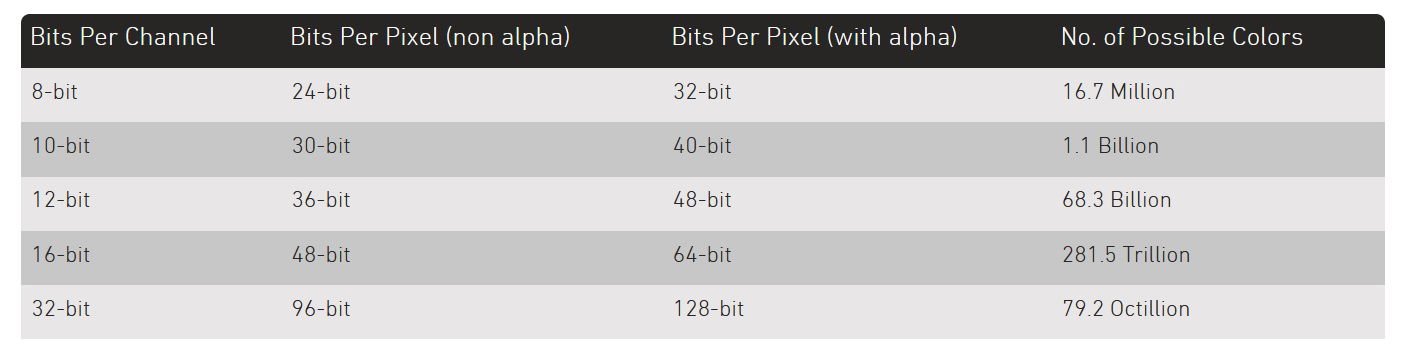

Al observar una señal RGB de 8 bits por canal, tenemos 256 valores posibles para cada uno de los canales/colores. Cuando se combinan, esto significa que hay 16,7 millones de combinaciones de colores posibles (256 x 256 x 256).

Esto puede parecer una gran cantidad, pero en realidad es lo que casi todas las pantallas que vemos a diario son capaces de reproducir y hay muchos casos de uso que requieren profundidades de bits aún mayores para evitar problemas notables con la calidad de la imagen, como veremos más adelante.

RGB + alfa

Además de tener tres canales de color, las imágenes a veces también pueden tener un cuarto canal llamado canal alfa. Un canal alfa contiene información de transparencia y normalmente tiene la misma profundidad de bits que los otros canales de color.

Esto significa que para una imagen en color en un sistema informático habrá 8 bits asignados por canal de color y, a veces, otros 8 bits para un canal alfa, lo que nos da un total de 32 bits por píxel (4×8 bits).

Profundidad de bits por píxel frente a profundidad de bits por canal

Este tema en concreto siempre causa mucha confusión. Si eres usuario de Photoshop o After Effectos, por citar dos programas universales de cualquier empresa de postproducción de imagen/video, sabrás que en ellos se hace referencia a cómo se asignan los bits por canal de color y la medida de, por ejemplo, 32 bits hace referencia a cuántos bits se requieren cuando se combinan todos los canales.

Esta distinción se reconoce técnicamente por el acrónimo «bpc» (bits por canal), pero más a menudo en la conversión casual, las personas supondrán que sabe a qué se refieren en función del contexto.

Por ejemplo, si alguien dijo que un renderizado se realizó en color de 12 bits, es muy probable que se refiera a que se exportó a 12 bits por color de canal. Esto se debe a que la alternativa significaría que tenían solo 4 bits por canal (12 bits divididos en los canales rojo, verde y azul), lo que está muy por debajo de los estándares profesionales.

Como referencia, aquí hay un desglose de cómo se reproducen los bits por canal cuando se calculan en bits por píxel.

¿Por qué usar profundidades de bits altas?

Existen múltiples razones que requieren pasar a profundidades de bit más altas. Entre estos se encuentran evitar las bandas de color (llamadas vulgarmente ‘capas de cebolla’) y la posterización; también para generar imágenes de alto rango dinámico (HDR) y por último, para mantener la calidad del vídeo mientras se manipula durante la fase de edición y postproducción. Hablemos un poco más de dos defectos mencionados un poco antes:

Banding

La formación de bandas se produce cuando la profundidad de un bit es demasiado baja y el ojo puede ver dónde se producen los cambios de tono/color en lugar en vez de ver un cambio gradual suave entre ellos.

A menudo, estas diferencias parecen bandas que atraviesan una imagen, de ahí el nombre. El ejemplo clásico donde observar este defecto en un vídeo o foto, que muestre un cielo en amanecer o atardecer, donde será muy difícil que con una profundidad de bit baja, se pueda representar con precisión el degradado en los tonos de azul a dorados típicos de ese momento del día.

Esas ‘capas de cebolla’ son un problema que puede aparecer regularmente para imágenes con 8 bits por canal o menos y, por esa razón, las cámaras de gama alta capturan a profundidades de bits más altas y los códecs de postproducción de manipulación de imagen (Open EXR, TIFF, Prores, DNxHR etc). Es muy dificil que se reproduzca ‘banding’ con profundidades de 12 y 16 bits.

Por ejemplo, el cine digital utiliza un codec de proyección JPEG2000 con una profundidad de 12 bpc (bits por canal) que le permite mostrar hasta 68 billones de combinaciones de colores diferentes, lo que permite reproducir con precisión incluso las diferencias más sutiles en colores, luces y sombras.

Posterización

La posterización es esencialmente el mismo problema que el ‘banding’ pero tiene un nombre diferente porque algunas imágenes no tienen grandes gradientes que terminan dividiéndose en «bandas» marcadas.

Esas otras veces, las imágenes se descompondrán en patrones más abstractos, manchas irregulares, empastadas y sin definición. Sobre todo en zonas de muchos matices acumulados, como pueda ser un plano general de una jungla con una cámara en movimiento, mientras hay una ligero viento que mueve tallos, hojas, etc.

El problema sigue siendo el mismo: en lugar de tener tonos de color próximos pero separados, el códec de vídeo es incapaz de determinar donde empieza uno y termina el siguiente y los combina en patrones artificiales que nada tiene que ver con la imagen original.

En la imagen de arriba, la posterización se puede ver claramente en la región de fondo donde se pierde el enfoque por la propia profundidad de campo asociada a la cámara/óptica.

Un fenómeno interesante sobre la posterización es que las áreas de alto detalle y contraste (alta frecuencia espacial) no parecen verse afectadas tanto desde el punto de vista de la percepción. Tomemos, por ejemplo, el árbol en el tercio derecho que está enfocado: sin el fondo, sería difícil decir que una profundidad de bits baja estaba afectando negativamente a esta imagen.

Esto se debe a que en áreas de alta frecuencia espacial, los colores limitados que se usan se alternan y se dividen mucho más rápidamente, lo que significa que nuestro ojo no puede detectar áreas que parecen tener gradientes más suaves en su lugar.

Por otro lado, las áreas que tienen una frecuencia espacial baja (como regiones fuera de foco o escenas de bajo contraste) tienen muchas más probabilidades de exhibir defectos de posterización.

Esto se debe a que es mucho más probable que las zonas grandes se reduzcan a un solo color, lo que a su vez los hace mucho más fáciles de detectar para nuestros ojos.