En la primera parte del artículo relativo a la profundidad de bits en la señal de vídeo SDR, analizamos su influencia a la hora de visualizar las imágenes con precisión y sus principales defectos asociados (banding y posterización). En esta segunda parte, centraremos la atención en los bit dedicados al video de alto rango dinámico (HDR).

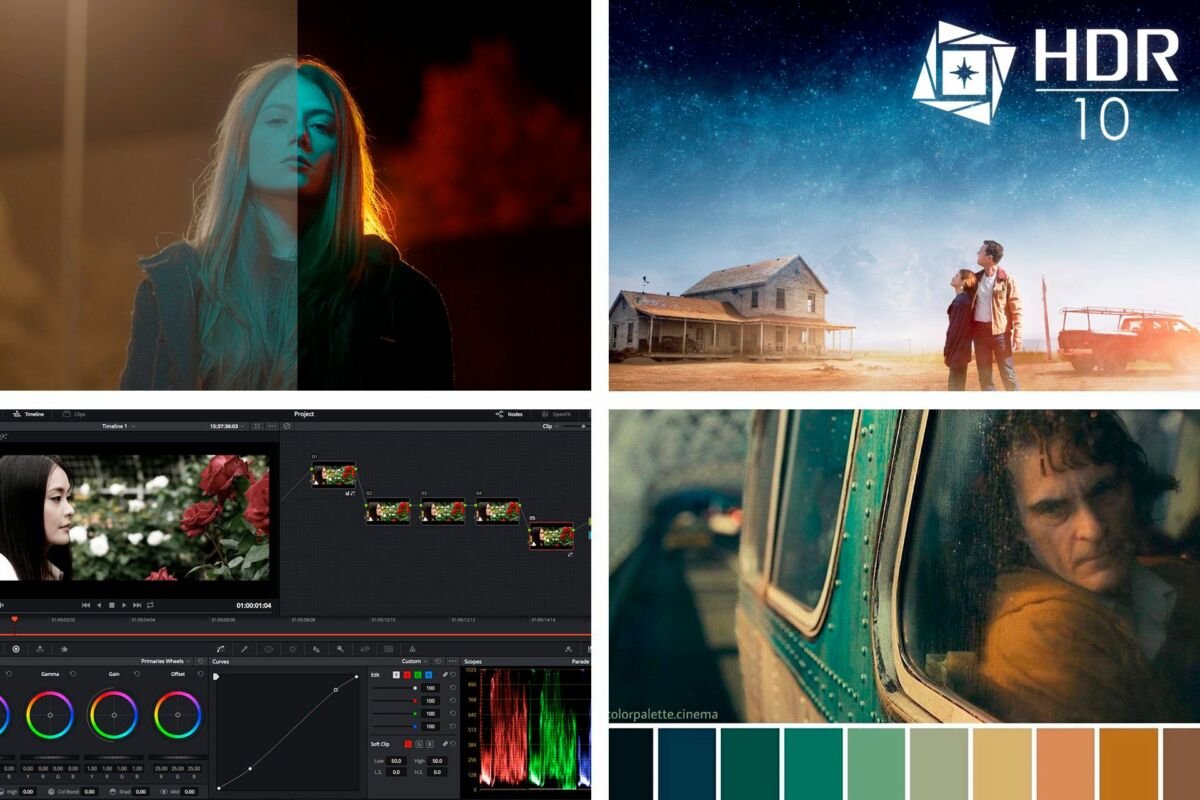

La llegada de los diferentes estándares de video HDR, hasta el más básico, ha incluido en sus especificaciones el paso a profundidades de bits altas para su gran rango dinámico de luminancia como para las gamas de colores más amplias (wide color gamut, en inglés, WCG). Tanto HDR como las gamas cromáticas amplias tienen el potencial de exacerbar los problemas de banding y posterización, ya que requieren más profundidad para representar más colores y gamas de luminancia mucho más brillantes.

Dicho de otro modo, si en SDR (rango dinámico estándar) era posible difuminar o esconder el banding con ciertas técnicas de postproducción (blur, dither…) en HDR la situación es mucho más crítica al tener mas muestras que tratar.

Gracias a la rápida adopción de la industria audiovisual en su conjunto del HDR y WCG, se ha empujado a los fabricantes de Tv, proyectores, media players etc a admitir, como mínimo, 10 bits por canal para evitar la introducción de bandas en el contenido. Dolby Vision (el estándar de HDR de Dolby) con una perspectiva de futuro y de calidad, va un paso más allá y requiere que el contenido se codifique a 12 bits por canal en un esfuerzo por prepararlo para el futuro y mitigar cualquier problema potencial.

Es bastante probable que la industria desarrolle televisores OLED-QD OLED de 12 bits de manera comercial en los próximos años y eso supondría liberar el pontencial de este HDR de Dolby. Empresas como Flanders Scientific, líderes en fabricar monitores para salas de color y postproducción de las más altas exigencias, ya tienen un modelo, el XM312 con un panel W-OLED de 12 bits con determinadas señales de video y denominado como ‘Dolby Vision mastering monitor». Eso sí, 32 pulgadas a 22.000 dólares aproximadamente.

Procesos de Post Producción

Entonces, ¿por qué demonios necesitaríamos 12 bits o más por canal para trabajar en la postproducción de una serie o película? Si bien es cierto que este nivel de profundidad de color está cerca de superar la visión humana para el monitoreo, a menudo se requieren profundidades de bits más altas por la superposición de tareas en los VFX y etalonaje.

Pensemos en que un solo plano de una peli de ciencia ficción puede llevar una docena de capas (con sus correspondientes canales alpha) para tener la composición final (p.ej un dinosaurio, en la loma de una montaña, con un cielo y sus nubes donde vuelan otros dinosaurios).

Si a eso le sumamos el proceso de etalonaje o corrección de color, se van a llevar al límite la información de luz y color de cada uno de esos elementos, lo que equivale estirar la profundidad de bits codificada en cada uno de ellos. Nadie quiere ver como asoma un banding o una posterización en un plano porque limita la libertad creativa que tienen los profesionales encargados de todas las tareas anteriores y la visión del director/a.

Otro uso para las profundidades de bits altas es la codificación de información de exposición adicional que se puede recuperar más tarde. Por ejemplo, el trabajo de efectos visuales (VFX) a menudo se procesa a 32 bits flotantes por canal utilizando valores de luz lineal, como en el formato de imagen Open EXR. Esto permite que los blancos súper brillantes (valores blancos más allá del punto de codificación normal) se almacenen sin pérdida y luego se manipulen más adelante.

Un colorista al que le llega un plano VFX a su sala de etalonaje, compuesto por varios VFX a 32 bits, podría comenzar a ajustar la exposición para que coincida con el resto de planos anteriores y posteriores de la escena y a recuperar detalles de los blancos que parecían haber sido recortados y perdidos previamente.

La rampa Barten

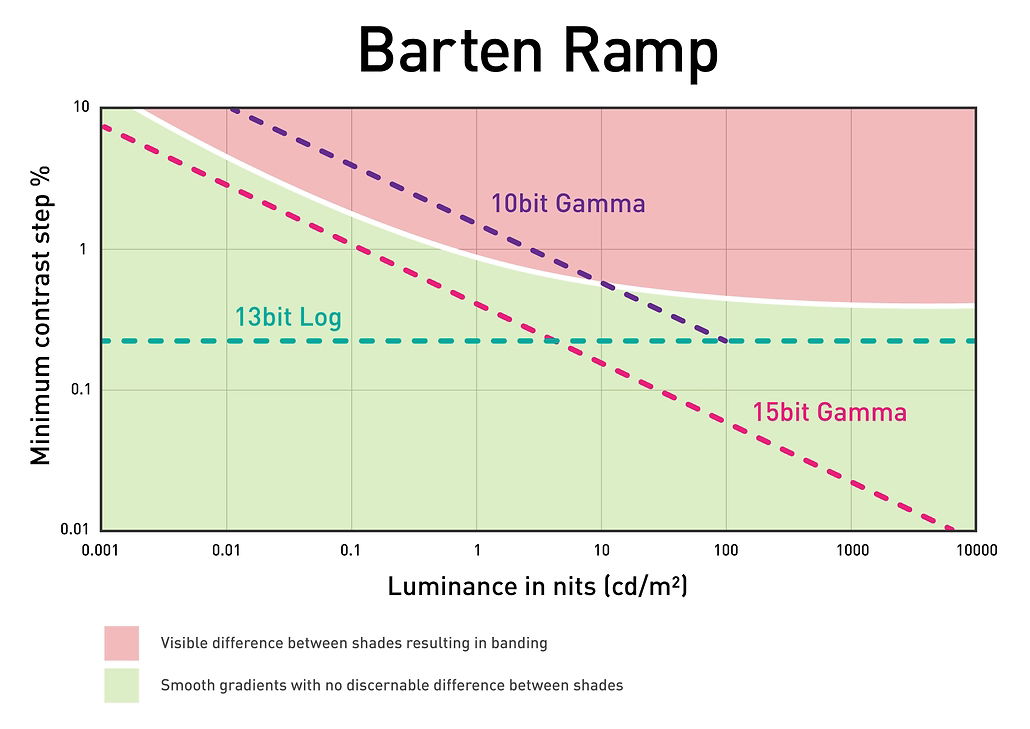

Como adelanto a lo que veremos en el próximo artículo sobre la gamma (luminosidad codificada), merece la pena introducir ahora un concepto fundamental para el vídeo HDR, derivada de esta profundidad del bit: la rampa Barten. Es un gráfico extremadamente útil que señala dónde la mayoría de las personas pueden comenzar a ver banding en un gradiente siguiendo la unidad de medida de los nits hasta los 10,000 nits para imágenes HDR. El área en verde muestra dónde no se visualiza el banding, y la zona en rojo muestra dónde sí aparecer y, por lo tanto, es problemática.

Para la calidad de la imagen, preferimos que la imagen permanezca por debajo del umbral de Barten en todo momento. Sin embargo, como se puede ver en la imagen de arriba, para hacer eso con una función de transferencia gamma estándar, necesitaríamos permitir 15 bits por canal. Si solo asignáramos 10 bits por canal, nuestras regiones más oscuras serán susceptibles de generar banding.

El problema es que esos 15 bits por canal son un requisito muy alto para los sistemas comerciales (¡y aún más para los sistemas domésticos!) y sobre todo, hacen un uso muy ineficiente de los datos: hay muchos más datos asignados en las porciones media y alta de la imagen de lo que requiere una codificación óptima similar a como funciona el ojo humano.

Una imagen con codificación logarítmica de 13 bits es algo más efectiva: tiene menor en profundidad de bits, permanece por debajo del umbral de Barten, pero tiene una codificación ineficiente de las sombras donde se asignan más valores de los necesarios. Si bien es cierto que no derrocha tanto en luces altas.

Ni imagenes con profundidad de 15 bits lineales ni 13 logarítmicos. Lo óptimo es una curva que se mantenga por debajo del umbral de Barten y siga la curva lo más cerca posible para mantener una eficiencia en la codificación. Y aquí es donde entra la norma ST. 2084, también conocida como la función de transferencia «PQ» de la que hablaremos próximamente para las profundidades de bit de 10 y 12.

En resumen, la rampa Barten es una referencia para entender cuanta profundidad de bit y de qué tipo son necesarios para evitar la aparición de banding en una imagen según su grado de nits. De ahí, se entiende perfectamente por ejemplo, porqué 10 bits lineales no son suficientes para evitar el banding por debajo de 100 nits.