El mapeo de tonos, mapeo tonal, o ‘tone mapping‘, es fundamental para ajustar las informaciones de luz y color de un contenido audiovisual HDR al dispositivo de visualización, ya sea un monitor, proyector o televisor. Imaginemos un escenario común: ¿qué sucede si queremos ver una película en formato HDR10, masterizada a 1.000 nits y con espacio de color P3, en un monitor que solo alcanza 600 nits y cubre el 80% del espectro P3?

Está claro que el color y la luminancia de esa película se verán comprometidos respecto al máster original almacenado en un Blu-ray o en el servidor de una plataforma en línea. Entonces, ¿cómo se adapta ese contenido a las limitaciones del monitor?

Para resolver esta discrepancia, que varía enormemente entre diferentes marcas y modelos de dispositivos, se utilizan unos metadatos cruciales en la fase de corrección de color o etalonaje: los del mapeo de tonos. Esta información, generalmente unos pocos kilobytes en formato XML, es inseparable de la serie o película y se integra en el propio archivo máster en formatos como .MXF o .IMF.

Ya hablamos con anterioridad en AVPasión sobre la explotación de contenido HDR de cada una de las principales plataformas de video bajo demanda como Netflix, Apple TV, Disney + etc. En esos reportajes aprendimos que era una práctica habitual generar un solo máster HDR, por ejemplo, un Dolby Vision del cual se auto-generaba una versión HDR10 y una versión SDR gracias a los metadatos generados para esos posibles ‘trims’ o pases de una supuesta película.

Por simplificar, nos vamos a centrar en el HDR basado en PQ (perceptual quantization), es decir, Dolby Vision, HDR10, & HDR10+. Estos tres formatos, utilizan metadatos integrados en la señal para proporcionar a la pantalla receptora información sobre los parámetros de la pantalla de clasificación y el contenido de la imagen, que la pantalla receptora utiliza para adivinar o sugerir su mejor configuración para mostrar el contenido de la imagen.

El término adivinar o sugerir, no lo utilizo con connotaciones negativas, sino porque la correcta aplicación de los metadatos depende de que la pantalla/proyector esté calibrada con precisión y, desafortunadamente, todavía existe un mayoritario parque de monitores, proyectores y televisores sin calibrar o configuradas a ‘ojímetro’. En cualquiera de estos escenarios mencionados, los metadatos no cumplirán bien su función.

Los metadatos HDR basados en PQ tienen dos formas: estática y dinámica

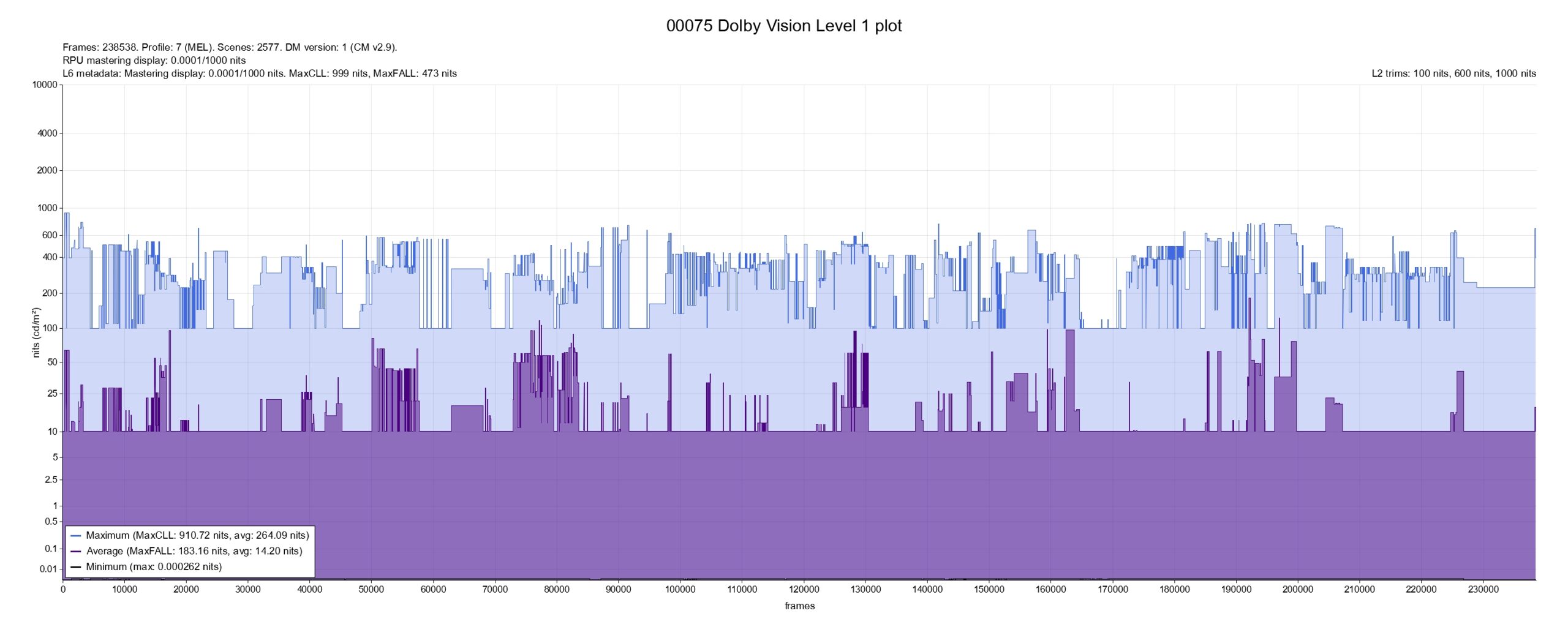

Tanto los metadatos estáticos como los dinámicos incluyen las coordenadas de cromaticidad para los primarios RGB de la pantalla de masterización, la cromaticidad del punto blanco y la luminancia mínima/máxima (MinDML y MaxDML). También incluye el nivel de luz promedio de fotograma máximo (MaxFALL), que es el brillo promedio de fotograma más alto dentro del programa/secuencia dado, y el nivel de luz de contenido máximo (MaxCLL), que define la luma del píxel más brillante.

El MaxFALL y el Max CLL son los datos que habitualmente muestro en las reviews de los discos Blu-ray 4K como podéis ver en este mapa de nits del disco Blu-ray 4K de ‘Dune 2’

Los metadatos estáticos, por su parte, utilizan los mismos valores durante toda la duración de un programa determinado, mientras que los metadatos dinámicos cambian con tanta frecuencia como sea necesario, incluso en cada frame o cuadro (potencialmente hasta 25 veces por segundo).

HDR10 usa metadatos estáticos, mientras que Dolby Vision y HDR10+ usan dinámicos.

¿Son necesarios los metadatos del mapeo de tonos?

Los metadatos son realmente necesarios solo por una razón: cuando se introdujo HDR (no han pasado ni diez años…) no había televisores que pudieran igualar la luminosidad máxima y la cobertura de gama de las pantallas de masterización/clasificación, específicamente la luma máxima. Con la naturaleza «absoluta» del HDR basado en PQ, no tener el mismo valor de luminosidad máxima que la pantalla de masterización es un problema, ya que la imagen se recortará.

Para intentar superar esto, se introdujeron metadatos para permitir que el televisor HDR reasignara el contenido de la imagen original para intentar camuflar sus capacidades menores: el famoso mapeo de tonos, que no es más que una reducción del mapa de tonos de la curva EOTF/gamma.

La forma en que se generan estos metadatos dinámicos también ayuda a definir la forma en que funcionan para la reproducción, lo que ayuda a comprender el enfoque general. Pero hablando en plata, la realidad es que en cuanto se use un solo metadato de mapeo tonal, ya no se está disfrutando del contenido tal cual lo diseñaron los responsables (director, fotografía, maquillaje, arte…).

Puede sonar muy negativo, pero desde un punto de vista purista, el uso de metadatos simplemente distorsiona la imagen vista de la intención del director y colorista, perdiendo potencialmente la respuesta emocional generada en la sala de corrección de color.

Evidentemente, hay que disfrutar de nuestras aficiones y no sufrir con estas cuestiones más de lo necesario. Pero lo uno no quita lo otro: está bien ser consciente de qué es y qué hacen los metadatos del mapeo de tonos en la misma medida que una buena fotografía en HDR nos hace sumergirnos en otros mundos, como un buen libro.

Generación de los metadatos

El enfoque básico para la generación de metadatos durante el etalonaje/masterización es realizar el primer pase del contenido HDR en una pantalla HDR profesional, sin ningún tipo de atenuación/mapeo de tonos, utilizando el brillo y la gama de colores más altos disponibles (mayoritariamente espacio P3 del 100% y entre 1000 y 4000 nits).

Luego, el metraje etalonado en HDR pasa a través de un sistema de análisis que reasignará las imágenes HDR a SDR, intentando mantener la intención HDR original, agregando metadatos dinámicos para definir los cambios entre el HDR original y la versión SDR. A menudo, el o la colorista ayudará con una corrección de color aprobada «limitada» para ayudar a mantener la intención artística original. De esta manera, los metadatos describen los cambios de gradación’ del máser HDR a la versión SDR.

Con estos metadatos disponibles, cuando el metraje HDR se reproduce en una pantalla HDR con un brillo máximo y/o una gama de colores menor que la pantalla de masterización original, la pantalla utiliza los metadatos dinámicos para reasignar el metraje a un punto entre un SDR mejorado y un HDR completo, según las capacidades del televisor de reproducción.

El problema es que pocos televisores domésticos aplican con precisión el mapeo correcto, distorsionando la intención artística original del metraje. Al menos hasta ahora, porque en hoy, en 2024, muchos televisores domésticos se están acercando a igualar las capacidades máximas de luma, gamma y color de la pantalla de la sala de corrección de color o masterización.

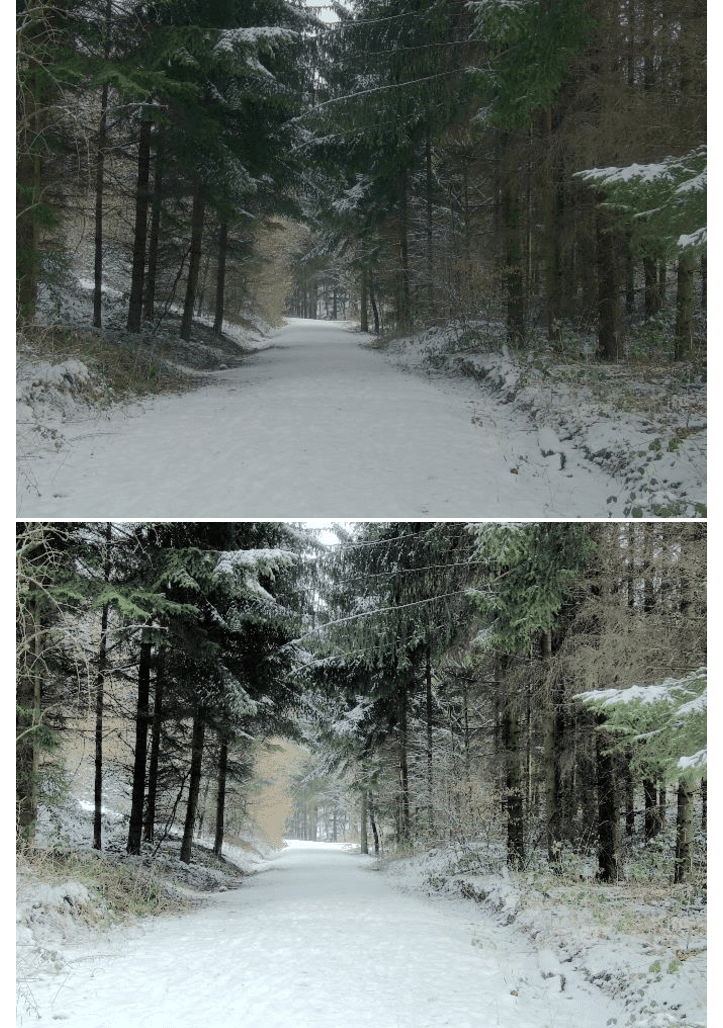

Esta simulación fotográfica de más abajo es una clara representación del problema: suponiendo que la imagen del bosque nevado está masterizada a 2.000 nits, una tele ‘marca X’ mapeará con preferencia a conservar el máximo luces altas a costa de empastar las sombras y una tele ‘marca Y’ hará el mapeo de tonos de manera distinta.

Si en nuestros hogares están entrando televisores con 1.000 o 2.000 nits calibrados y con un espacio de color del 90% del REC 2020, estamos hablando de que, en general, son las mismas especificaciones que muchos monitores profesionales. Lo que abre una pregunta interesante de cara al futuro próximo: si el televisor doméstico coincide en rendimiento general con la pantalla de la sala de color ¿necesitaremos metadatos?

De hecho, el HDR no basado en PQ, como el HLG (hybrid log gamma) de las transmisiones en directo, no necesita metadatos o al menos no del tipo de los anteriormente descritos. Una de las principales diferencias es el uso de un estándar HDR basado en escala relativo, en lugar de absoluta del PQ.

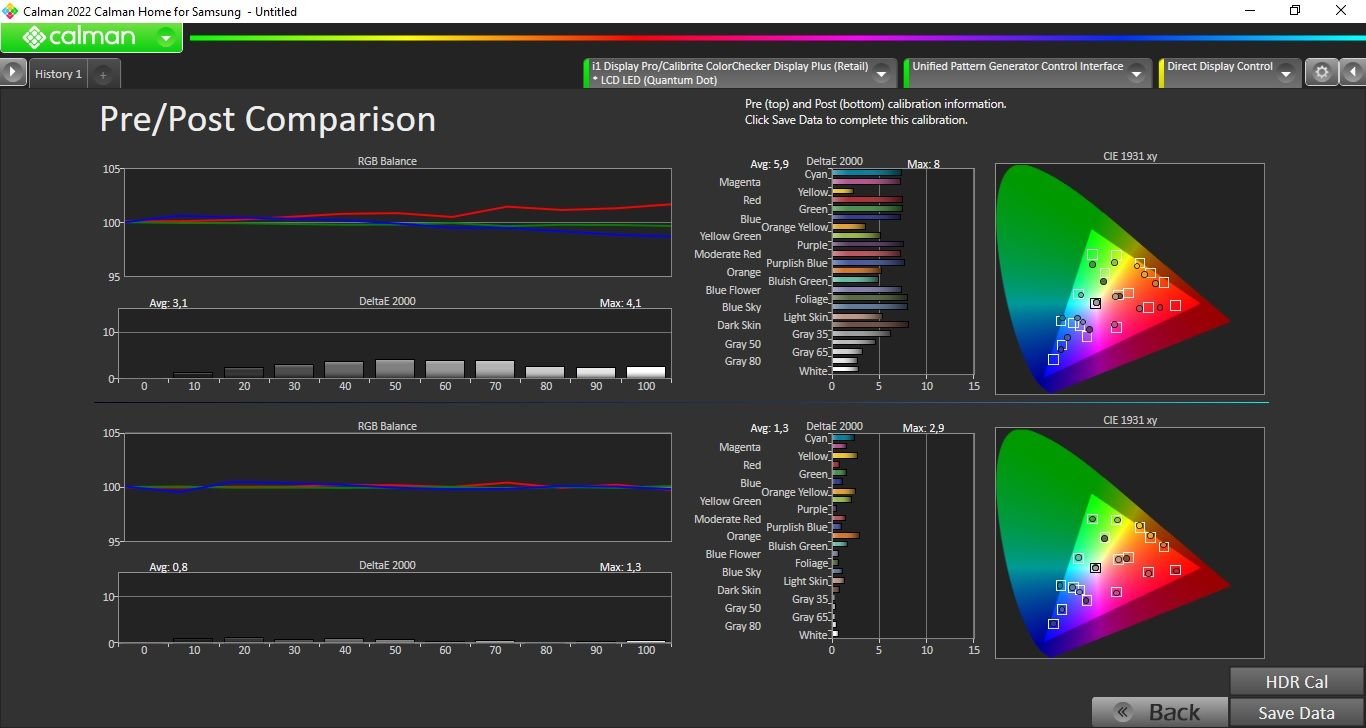

Comparaciones calibradas de pantallas HDR

Comprender lo anterior con respecto a la necesidad, o no, de metadatos plantea una idea interesante sobre cómo se pueden comparar diferentes pantallas HDR.

Primero, supongamos que todas las pantallas HDR modernas puedan alcanzar un nivel de luminancia máximo determinado, digamos 1000 nits y un 90% del espacio P3; evidentemente calibrada por sonda. En segundo lugar, elegimos una película masterizada a 1.000 nits, utilizando una gama que esté dentro de la especificación y sin salirse del P3.

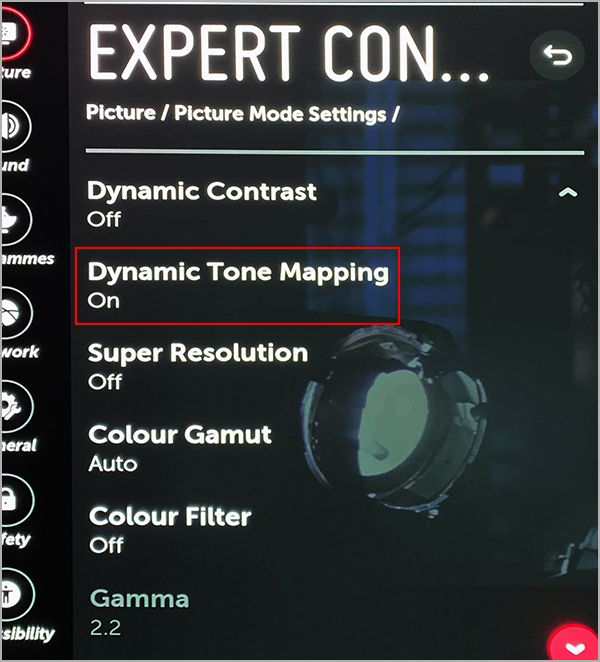

Si no hubiera fallo alguno, el largometraje HDR no debería activar ningún procesamiento basado en ‘metadatos’ (mapeo de tonos) dentro de la pantalla de reproducción, lo que permitiría una comparación directa del rendimiento de volumen de color entre diferentes televisores.

A partir de esta primera comparación, sería un paso adicional relativamente sencillo comparar las mismas pantallas con diferentes materiales originales masterizados a más de 2.000 nits, con una gama P3 completa, lo que permitiría sacar conclusiones del mapeo de tonos encendido y apagado de las pantallas por separado.

Otra posible razón para el uso de metadatos es permitir que el televisor receptor comprenda qué componente del flujo de imágenes debe usar, por ejemplo, en los discos Blu-ray 4K con HDR de flujo dual: HDR10 y Dolby Vision.

El mismo máster, pantallas similares y diferentes experiencias del HDR

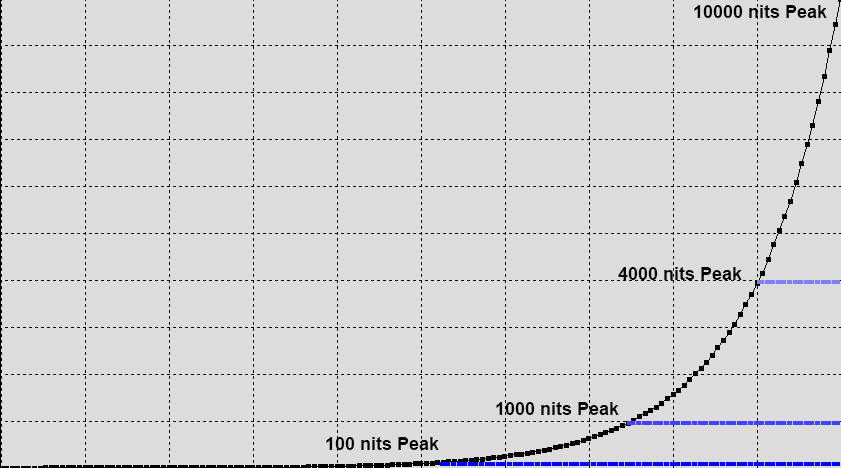

Obviamente, diferentes pantallas HDR tienen diferentes capacidades de luminancia máxima, por lo que la imagen mostrada deberá recortarse al valor máximo de nits disponible, como se define en el gráfico PQ EOTF que os mostramos aquí abajo:

Un clipping o recorte del pico de luz está controlado por los metadatos dentro de la señal, que definen la luminancia máxima de la pantalla del usuario para realizar la adaptación/reducción del contenido representado, estableciendo un valor o nivel de ‘clipeado’ correcto.

La forma en que se realiza este clipping, puede ser dura (tajo o hachazo, según la jerga de cada uno) o un clip suave, con roll-off y no se ha definido ni estandarizado en HDR10 o 10+. Solo está descrito y oficializado en Dolby Vision, que es un estándar HDR completamente definido, con todos los aspectos desde la generación inicial hasta su masterización. Y que cuenta con unas especificaciones preestablecidas que, por supuesto, usarlas conlleva un coste económico por licencia para cualquier dispositivo que lo adopte.

Así que nos encontramos con una situación endemoniada. Especialmente para los pobres calibradores profesionales, que tanto sufren esas frases del tipo: ‘‘pues en mi otra tele no se ve igual que aquí» y similares. En otras palabras, la realidad es que es muy poco probable que dos pantallas presenten la misma imagen HDR de la misma manera, incluso si tienen exactamente la misma capacidad de picos de nits, ya que el proceso utilizado para el mapeo de tonos de luminosidad varía.

El mapeo de tonos de Dolby Vision

Seguimos complicando la situación y es que ni con Dolby Vision dos televisores de las mismas prestaciones se verán igual. Es conocido que solo Panasonic sigue al 100% la implementación de las especificaciones Dolby Vision. El resto de marcas, la usa pero de “aquella manera”.

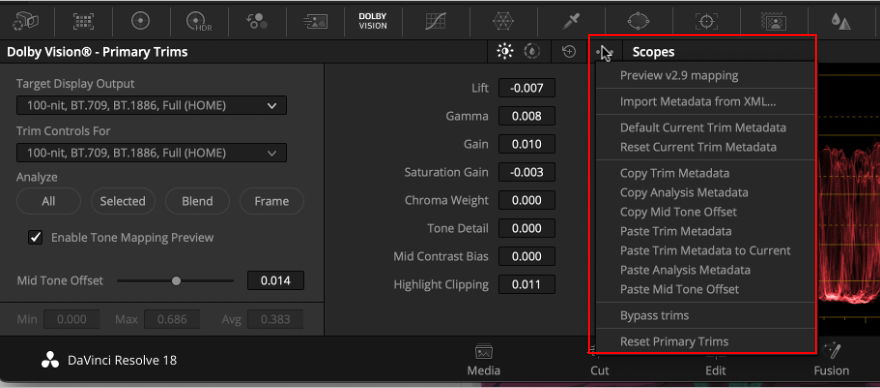

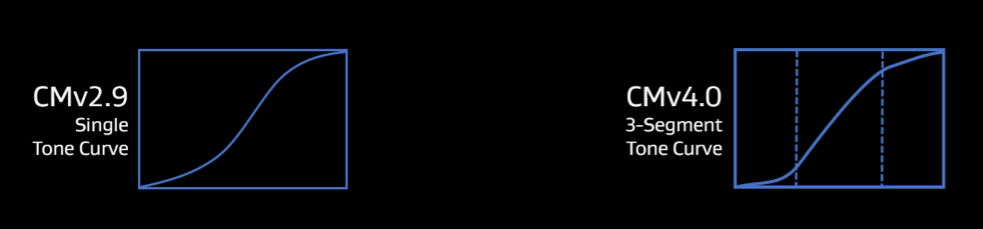

Dolby llama al mapeo tonal ‘content mapping’ y tienen en vigor dos versiones, la v2.9 y la v4. Curiosamente, la más moderna, es la que se usa en las plataformas online (pongamos por caso Netflix) y la más antigua es la que se usa mayoritariamente en las autorías de discos Blu-ray 4K. ¡Puntazo a favor del streaming!.

El caso es que el content mapping v2.9 de Dolby se basa en una curva de un único segmento de ajuste tonal mientras que el mapeo de tonos v4.0 tiene tres segmentos diferenciados sobre los que codificar la imagen y sacarle el máximo partido. En este gráfico se ven claramente las diferencias entre ambas:

Además, la v4.0 utiliza algoritmos mejorados y una curva de tono avanzada y más compleja que permite un mejor mapeo de tonos y más controles durante el proceso de ajuste de Dolby Vision. Como dijimos antes, esto es muy relevante porque los metadatos de Dolby Vision viajan con el contenido asociado e indican a los dispositivos de reproducción Dolby Vision cómo se debe reproducir un contenido y/o su adaptación.

Es decir, cómo se transforma un máster DV en una pantalla sólo HDR10; o peor aún, cómo transformar ese DV en un SDR. Y más complicado todavía, por qué entre fabricantes la implementación de las numerosas (demasiadas) versiones y perfiles Dolby puede cambiar significativamente. Incluso aunque solo sea porque una pantalla llega a 400 nits y otra a los 800.

En resumen y por concretar: no es lo mismo un televisor WOLED de 2024 que una WOLED de 2020. Ambos son DV, sí; van a mostrar igual las imágenes, no. Es desesperante y hay que estudiar, sí. ¿Acabará algún día todo esto? probablemente, no.